Dissecação de um Transformer Minimalista: Revelando o Funcionamento Interno de LLMs com 10 mil Parâmetros

2025-09-04

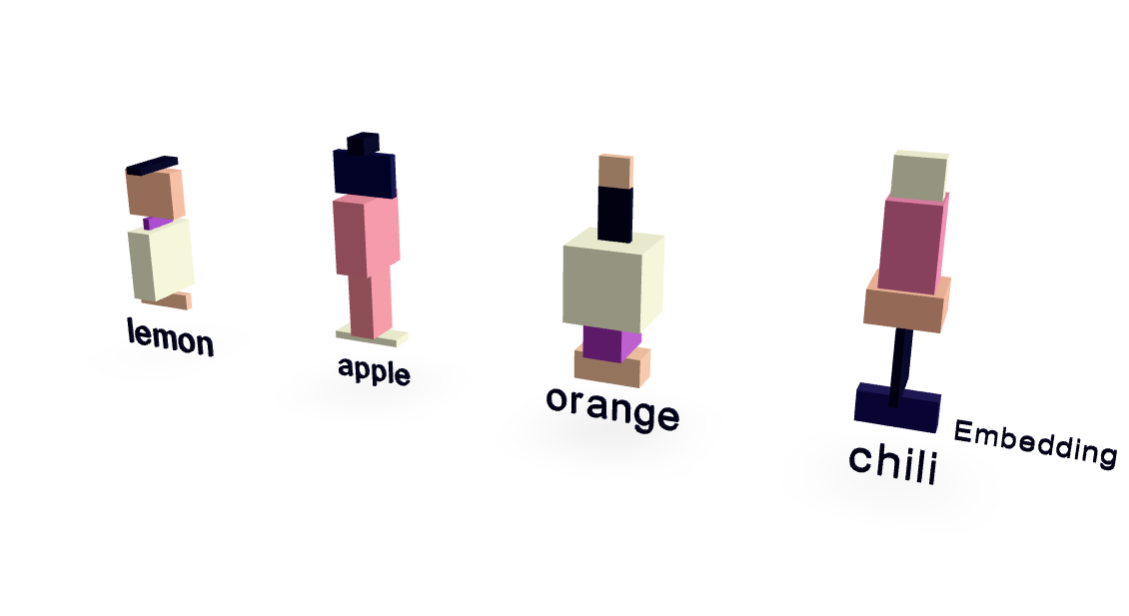

Este artigo apresenta um modelo Transformer radicalmente simplificado com apenas ~10.000 parâmetros, oferecendo uma visão clara do funcionamento interno de modelos de linguagem grandes (LLMs). Usando um conjunto de dados mínimo focado em relacionamentos entre frutas e sabores, os autores alcançam um desempenho surpreendentemente forte. Visualizações revelam como os embeddings de palavras e o mecanismo de atenção funcionam. Crucialmente, o modelo generaliza além da memorização, prevendo corretamente "pimenta" quando solicitado com "Eu gosto de picante então eu gosto de", demonstrando os princípios básicos da operação de LLM de uma maneira muito acessível.

IA