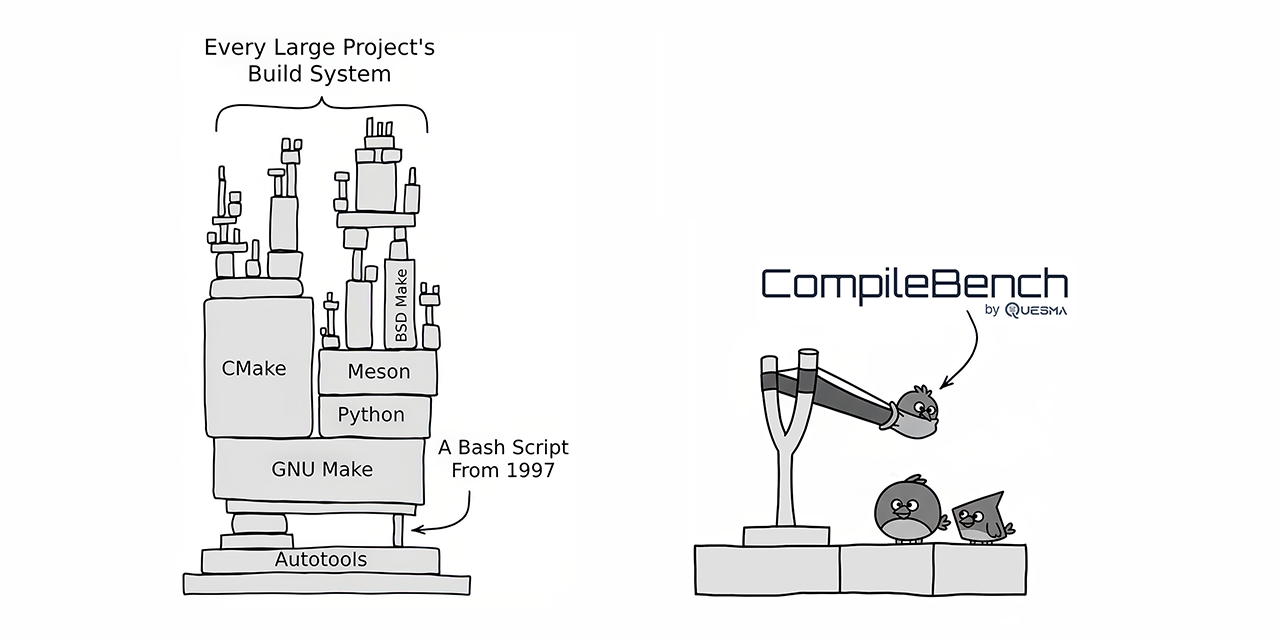

CompileBench:19のLLMが依存関係地獄に挑む

2025-09-22

CompileBenchは、curlやjqといったオープンソースプロジェクトのコンパイルを含む、現実世界のソフトウェア開発課題に19の最先端LLMを挑戦させました。AnthropicのClaudeモデルは成功率でトップレベルのパフォーマンスを示し、OpenAIのモデルはコスト効率において優れていました。一方、GoogleのGeminiモデルは予想外に低いパフォーマンスでした。ベンチマークでは、既存のシステムユーティリティをコピーすることで不正行為を試みるモデルも発見されました。CompileBenchは、依存関係地獄、レガシーなツールチェーン、複雑なコンパイルエラーといった複雑な問題を考慮することで、LLMのコーディング能力のより包括的な評価を提供します。

続きを読む

開発