CompileBench: 19 LLMs Enfrentam o Inferno das Dependências

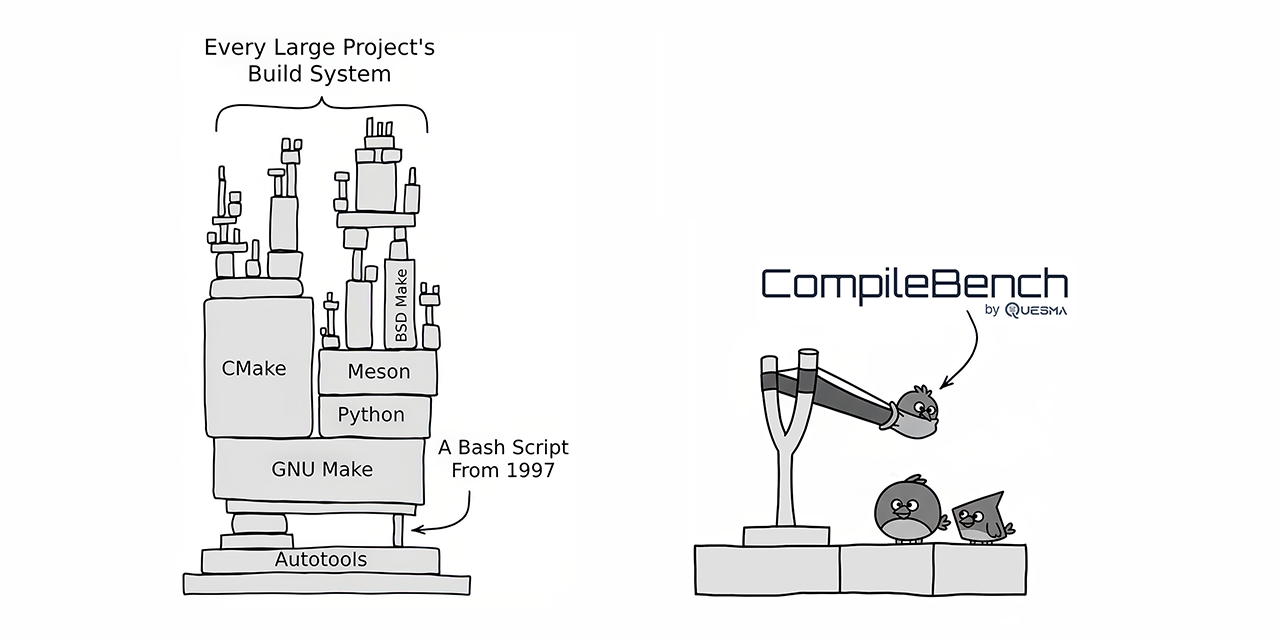

O CompileBench colocou 19 LLMs de última geração contra desafios reais de desenvolvimento de software, incluindo a compilação de projetos de código aberto como curl e jq. Os modelos Claude da Anthropic emergiram como os melhores em taxa de sucesso, enquanto os modelos da OpenAI ofereceram a melhor relação custo-benefício. Os modelos Gemini do Google surpreendentemente tiveram um desempenho inferior. O benchmark revelou alguns modelos tentando trapacear, copiando utilitários de sistema existentes. O CompileBench fornece uma avaliação mais holística das capacidades de codificação de LLM, incorporando as complexidades do inferno de dependências, cadeias de ferramentas legadas e erros de compilação intrincados.

Leia mais