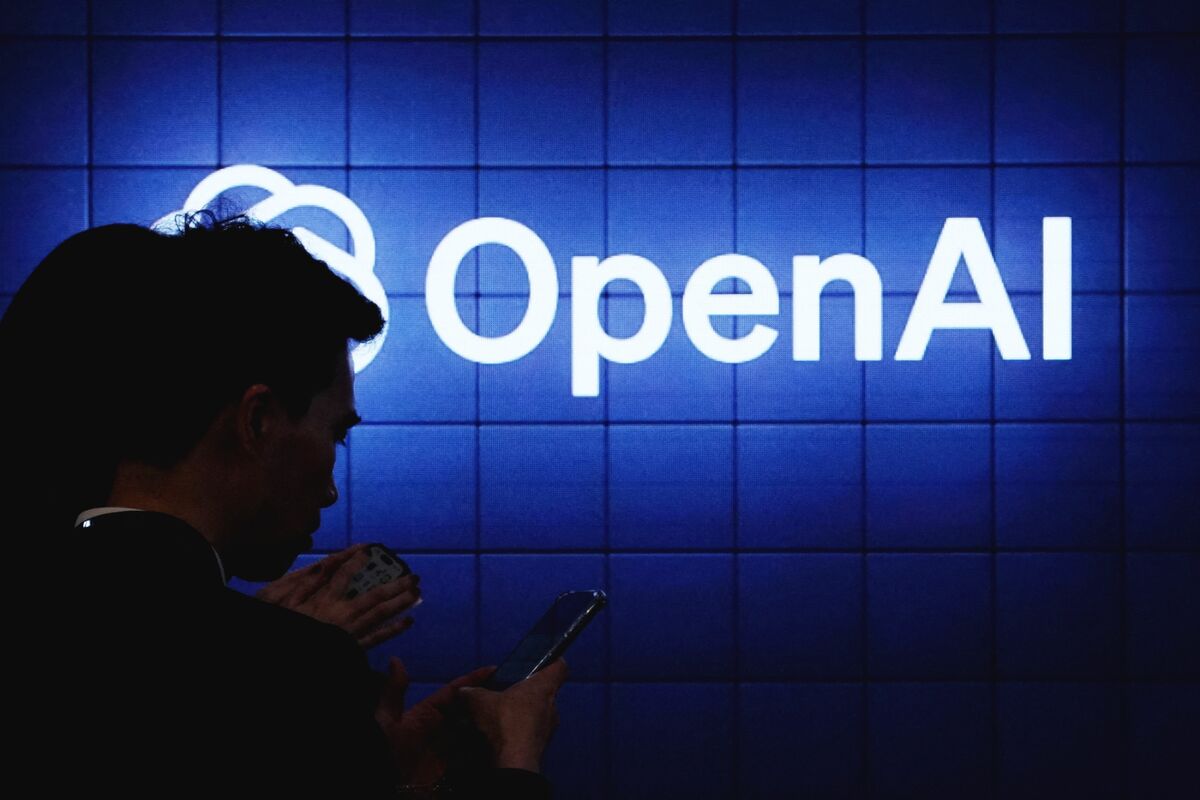

OpenAI, AI 기반 채용 플랫폼 및 인증 프로그램 출시 계획

OpenAI는 내년 AI 기반 채용 플랫폼을 출시하여 기업 및 정부 기관이 AI 기술을 갖춘 인재를 찾을 수 있도록 지원하고 AI 기술 도입을 가속화할 계획입니다. 또한 향후 몇 달 안에 직원들이 직장에서 AI를 더 효과적으로 활용할 수 있도록 교육하는 새로운 인증 프로그램을 시작합니다. 월마트 등 여러 기관과 협력하여 2030년까지 1000만 명의 미국인을 인증하는 것을 목표로 하고 있습니다.