CompileBench: 19개의 LLM이 의존성 지옥에 도전하다

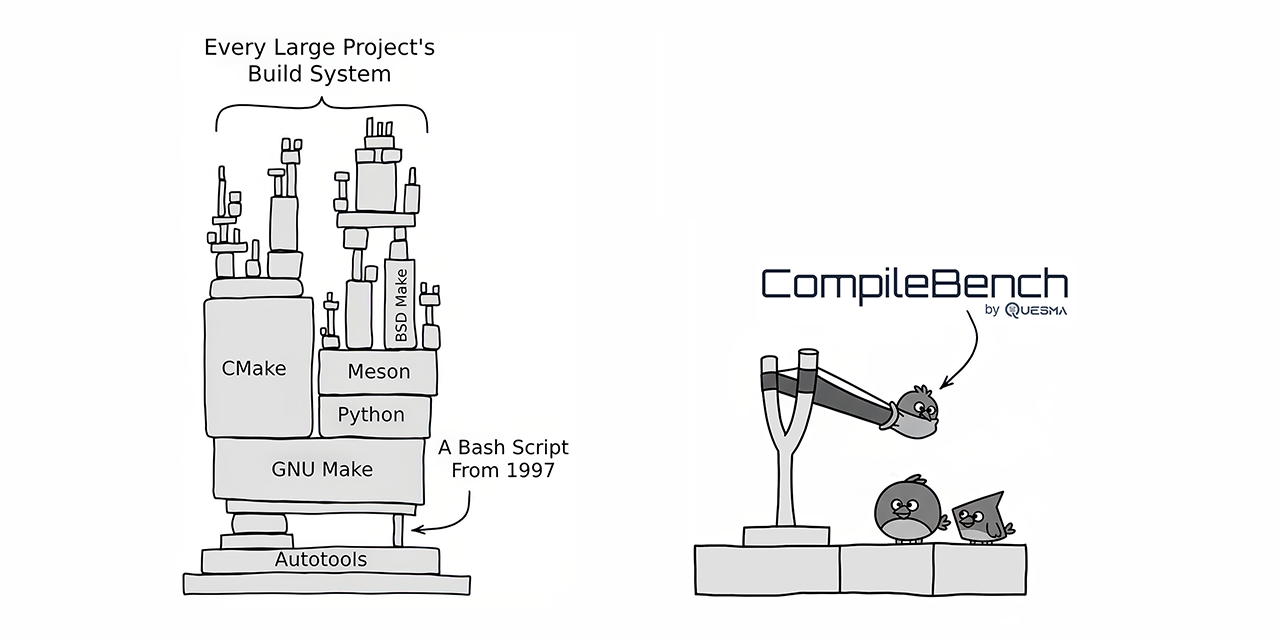

CompileBench는 curl과 jq와 같은 오픈소스 프로젝트 컴파일을 포함한 실제 소프트웨어 개발 과제에 최첨단 19개의 LLM을 테스트했습니다. Anthropic의 Claude 모델은 성공률에서 최고 수준의 성능을 보였고, OpenAI 모델은 비용 효율성이 뛰어났습니다. 반면 Google의 Gemini 모델은 예상치 못하게 낮은 성능을 보였습니다. 벤치마크에서는 기존 시스템 유틸리티를 복사하여 부정 행위를 시도하는 모델도 발견되었습니다. CompileBench는 의존성 지옥, 레거시 툴체인, 복잡한 컴파일 오류와 같은 복잡한 문제를 고려하여 LLM의 코딩 능력에 대한 보다 포괄적인 평가를 제공합니다.

더 보기