Du Hype de l'IA aux Chaînes de Markov : Un Retour aux Fondamentaux

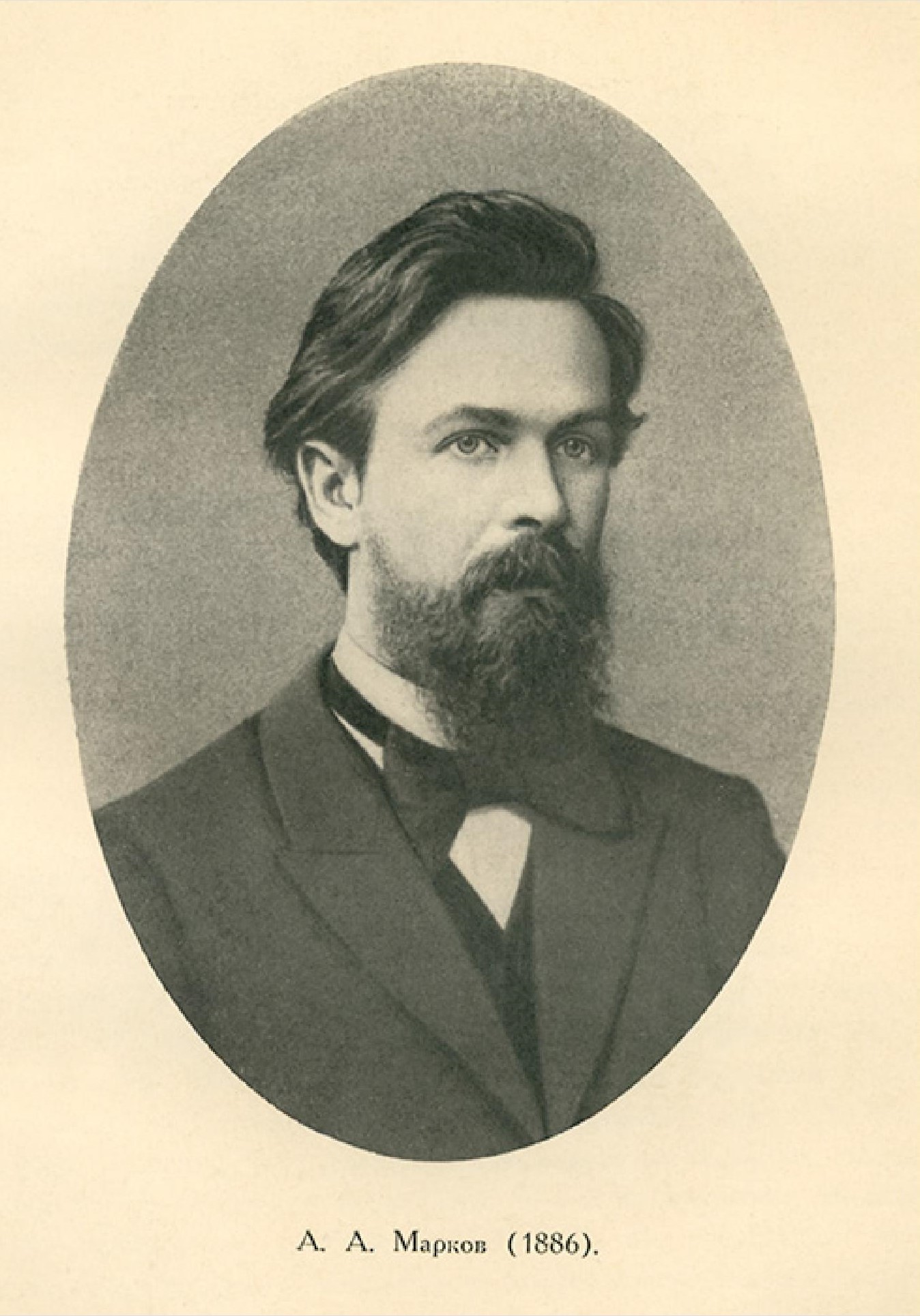

L'auteur raconte son parcours à travers les quatre étapes du cycle d'engouement pour l'IA concernant les grands modèles de langage : émerveillement initial, frustration ultérieure, confusion persistante et ennui final. Fatigué du flux constant de nouveaux modèles, l'auteur a décidé de revenir aux fondamentaux et d'explorer les chaînes de Markov. L'article détaille comment construire une fonction d'autocomplétion de texte à l'aide de chaînes de Markov, en couvrant la construction de matrices de transition, les calculs de probabilité et l'application à la génération de texte. Cet article explore non seulement les principes des chaînes de Markov, mais reflète également les réflexions de l'auteur sur l'état actuel du développement de l'IA et son désir d'explorer des technologies plus fondamentales.

Lire plus