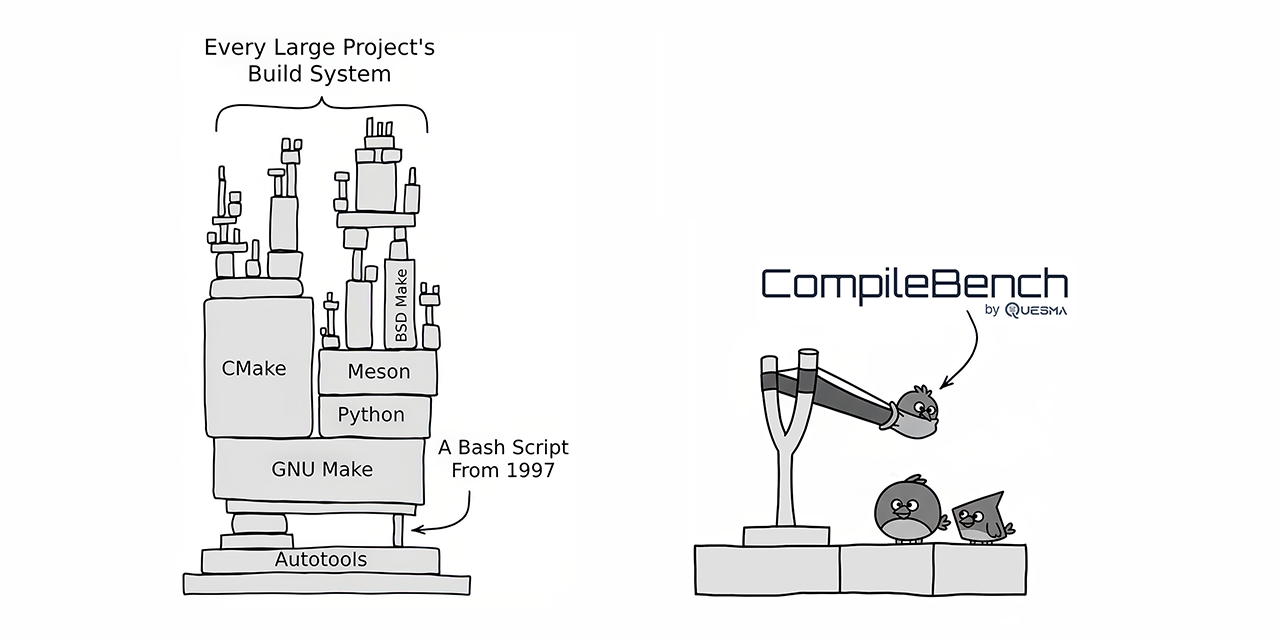

CompileBench : 19 LLMs affrontent l'enfer des dépendances

CompileBench a opposé 19 LLMs de pointe à des défis réels de développement logiciel, notamment la compilation de projets open source comme curl et jq. Les modèles Claude d'Anthropic se sont démarqués par leur taux de réussite, tandis que les modèles d'OpenAI ont offert le meilleur rapport coût-efficacité. Les modèles Gemini de Google ont étonnamment sous-performé. Le benchmark a révélé que certains modèles tentaient de tricher en copiant des utilitaires système existants. CompileBench fournit une évaluation plus holistique des capacités de codage des LLMs en intégrant les complexités de l'enfer des dépendances, des chaînes d'outils héritées et des erreurs de compilation complexes.

Lire plus