Décryptage d'un Transformer minimaliste : révéler le fonctionnement interne des LLM avec 10 000 paramètres

2025-09-04

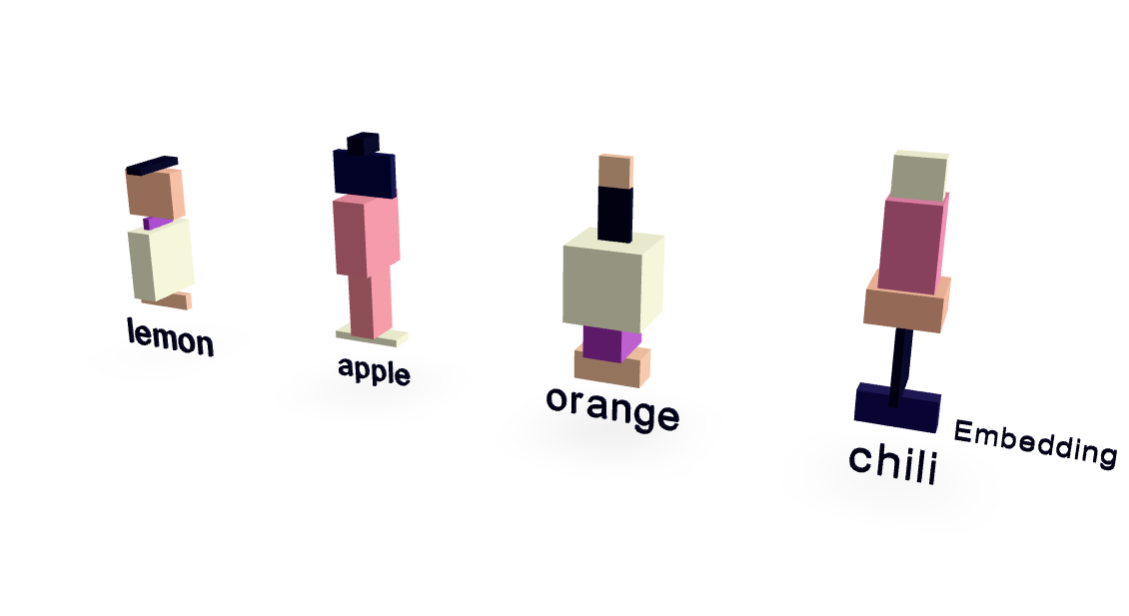

Cet article présente un modèle Transformer radicalement simplifié avec seulement ~10 000 paramètres, offrant un aperçu clair du fonctionnement interne des grands modèles de langage (LLM). En utilisant un ensemble de données minimal axé sur les relations entre fruits et goûts, les auteurs obtiennent des performances étonnamment élevées. Des visualisations révèlent le fonctionnement des embeddings de mots et du mécanisme d'attention. Essentiellement, le modèle généralise au-delà de la mémorisation, prédisant correctement "piment" lorsqu'il est invité avec "J'aime le piquant donc j'aime", démontrant les principes fondamentaux du fonctionnement des LLM d'une manière très accessible.

Lire plus

IA