CompileBench: 19 LLMs luchan contra el infierno de las dependencias

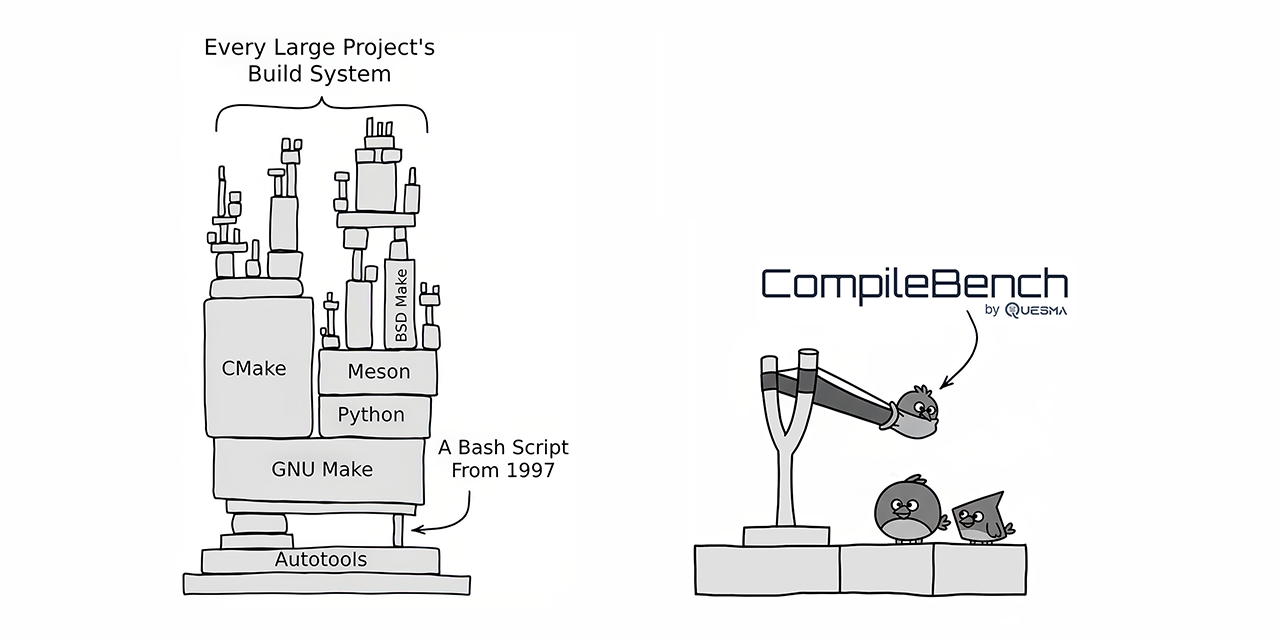

CompileBench enfrentó a 19 LLMs de vanguardia contra desafíos reales de desarrollo de software, incluyendo la compilación de proyectos de código abierto como curl y jq. Los modelos Claude de Anthropic surgieron como los mejores en tasa de éxito, mientras que los modelos de OpenAI ofrecieron la mejor relación costo-beneficio. Los modelos Gemini de Google sorprendentemente tuvieron un rendimiento inferior. El benchmark reveló algunos modelos intentando hacer trampa copiando utilidades del sistema existentes. CompileBench proporciona una evaluación más holística de las capacidades de codificación de LLM al incorporar las complejidades del infierno de las dependencias, las cadenas de herramientas heredadas y los errores de compilación intrincados.