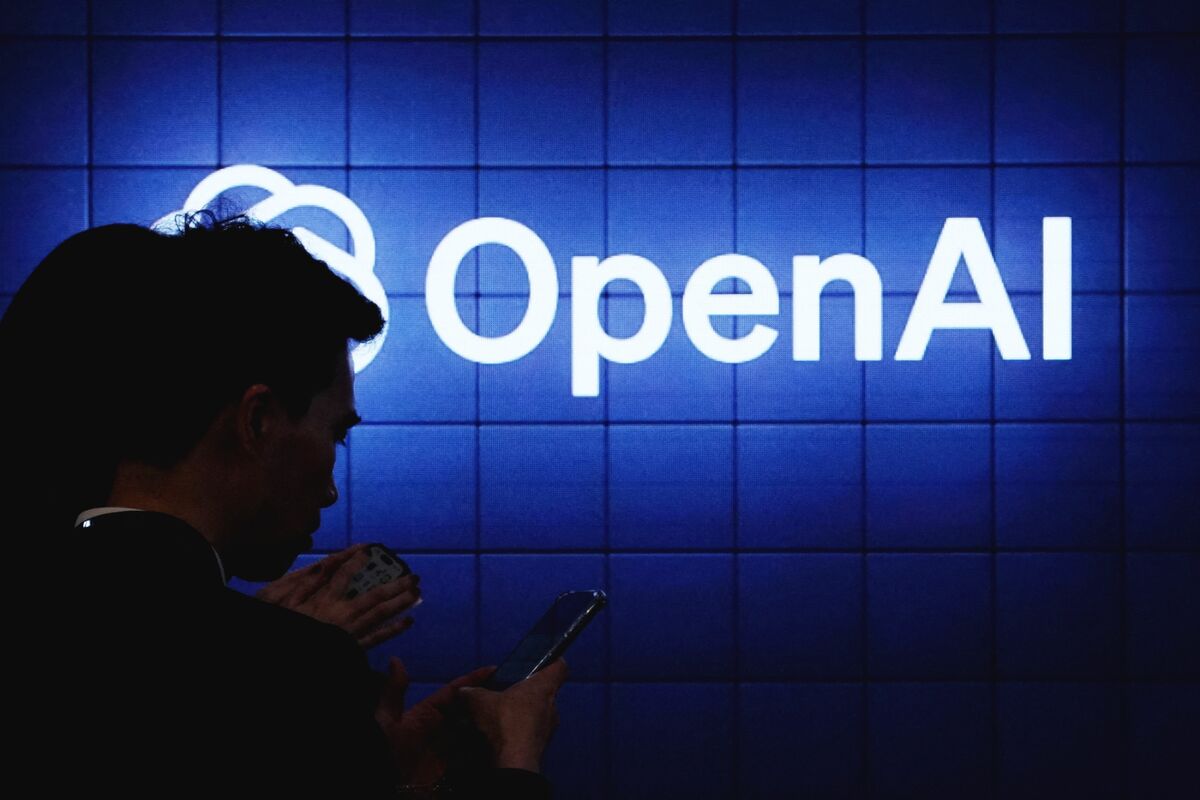

OpenAI: Plataforma de empleo con IA y programa de certificación

OpenAI planea lanzar el próximo año una plataforma de empleo impulsada por IA para conectar a empleadores con candidatos que tengan habilidades en inteligencia artificial, con el objetivo de acelerar la implementación de la tecnología en empresas y organismos gubernamentales. También lanzará un nuevo programa de certificación en los próximos meses para enseñar a los trabajadores a utilizar mejor la IA en el trabajo. OpenAI está trabajando con varias organizaciones en este programa, incluida Walmart Inc., el mayor empleador privado de EE. UU. OpenAI dijo que planea certificar a 10 millones de estadounidenses para 2030.