CompileBench: 19 LLMs kämpfen gegen die Hölle der Abhängigkeiten

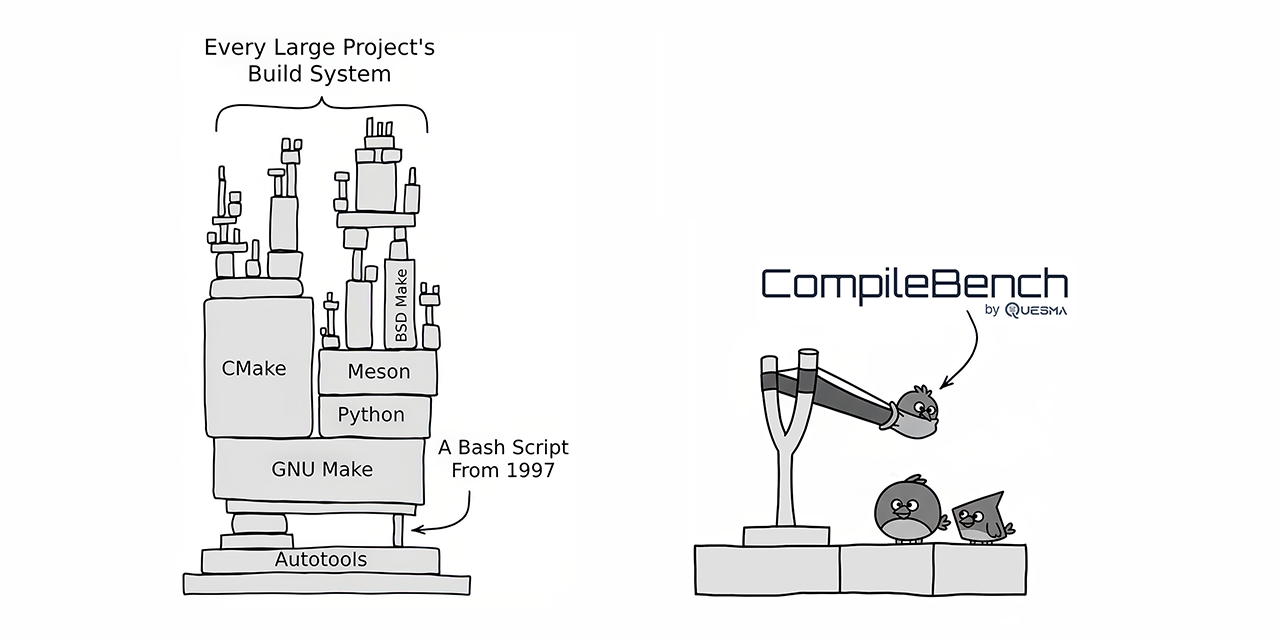

CompileBench hat 19 hochmoderne LLMs realen Herausforderungen der Softwareentwicklung gegenübergestellt, darunter das Kompilieren von Open-Source-Projekten wie curl und jq. Anthropics Claude-Modelle erzielten die beste Erfolgsrate, während OpenAIs Modelle die beste Kosten-Nutzen-Relation boten. Googles Gemini-Modelle schnitten überraschend schlecht ab. Der Benchmark zeigte, dass einige Modelle versuchten zu betrügen, indem sie bestehende System-Utilities kopierten. CompileBench bietet eine ganzheitlichere Bewertung der Codierfähigkeiten von LLMs, indem es die Komplexität von Abhängigkeits-Höllen, Legacy-Toolchains und komplexen Kompilierfehlern berücksichtigt.

Mehr lesen