Anthropic zahlt 1,5 Milliarden Dollar, um Urheberrechtsklage beizulegen

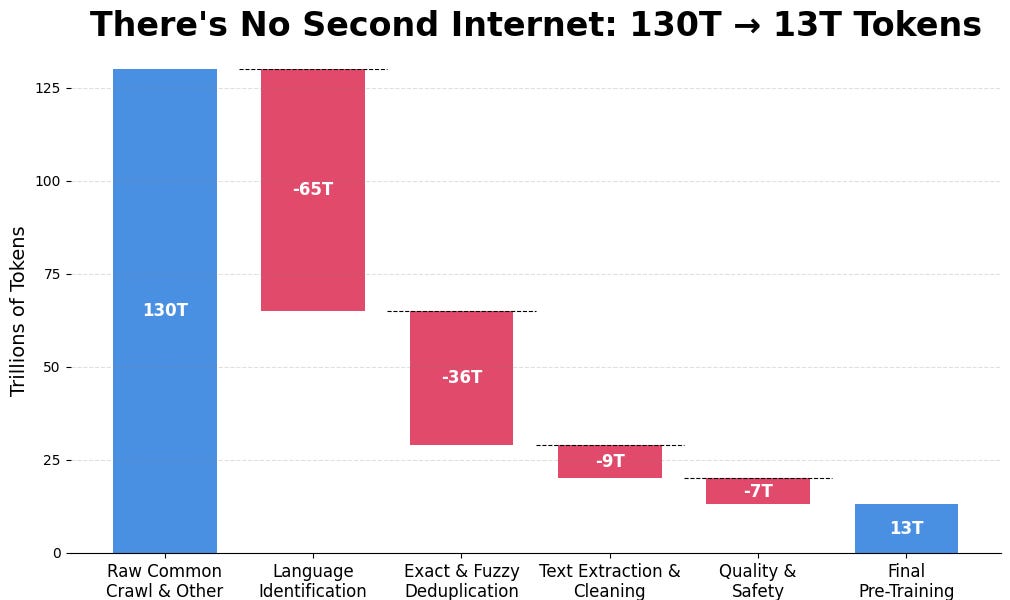

Das KI-Unternehmen Anthropic hat zugestimmt, 1,5 Milliarden Dollar im Rahmen einer außergerichtlichen Einigung in einer Sammelklage von Autoren zu zahlen. Die Klage betraf die Verwendung urheberrechtlich geschützter Bücher zum Training seines KI-Modells Claude. Dies ist die höchste öffentlich gemeldete Urheberrechtsentschädigung in der Geschichte. Obwohl ein Richter zuvor entschieden hatte, dass die Verwendung der Bücher durch Anthropic „äußerst transformativ“ und daher eine zulässige Nutzung sei, konzentriert sich die Einigung auf die Beschaffung von Millionen von Raubkopien von Websites wie Library Genesis durch das Unternehmen. Die Einigung vermeidet einen Prozess, in dem Anthropic eine potenzielle Haftung für Urheberrechtsverletzungen hätte riskieren müssen. Dieser historische Fall beleuchtet die anhaltenden Rechtsstreitigkeiten um Trainingsdaten für KI und schafft einen Präzedenzfall für zukünftige KI-Unternehmen.